Online casinos have been around for almost two decades now, and despite the fact that they’ve been around for a long time, there are still plenty of curious situations that…

The Most Curious Situations Happened In The Online Casino

Online casinos have been around for almost two decades now, and despite the fact that they’ve been around for a long time, there are still plenty of curious situations that…

In the last few years, space technology has made some incredible leaps forward. New developments in telescopes, satellites, and other space-based equipment have led to some amazing discoveries about our…

Technologies have transformed the way we live, work, and communicate. They've made our lives easier and more efficient. We can now connect with anyone in the world with just a…

We cannot imagine our lives without love, but in some cases, we are not too careful about it. In the following article, we will tell you about the 5 best…

We may think that our manners are impeccable, but there can always be something that does not show us in the most favourable light or even causes real embarrassment. Here…

There is no question that Shakespeare's works are still relevant in modern society. His plays deal with timeless themes that are still relevant today, such as love, betrayal, ambition, and…

Underrated destinations are often more authentic, and offer a more unique experience than popular tourist traps. They are also usually less crowded and less expensive. By exploring these places, you…

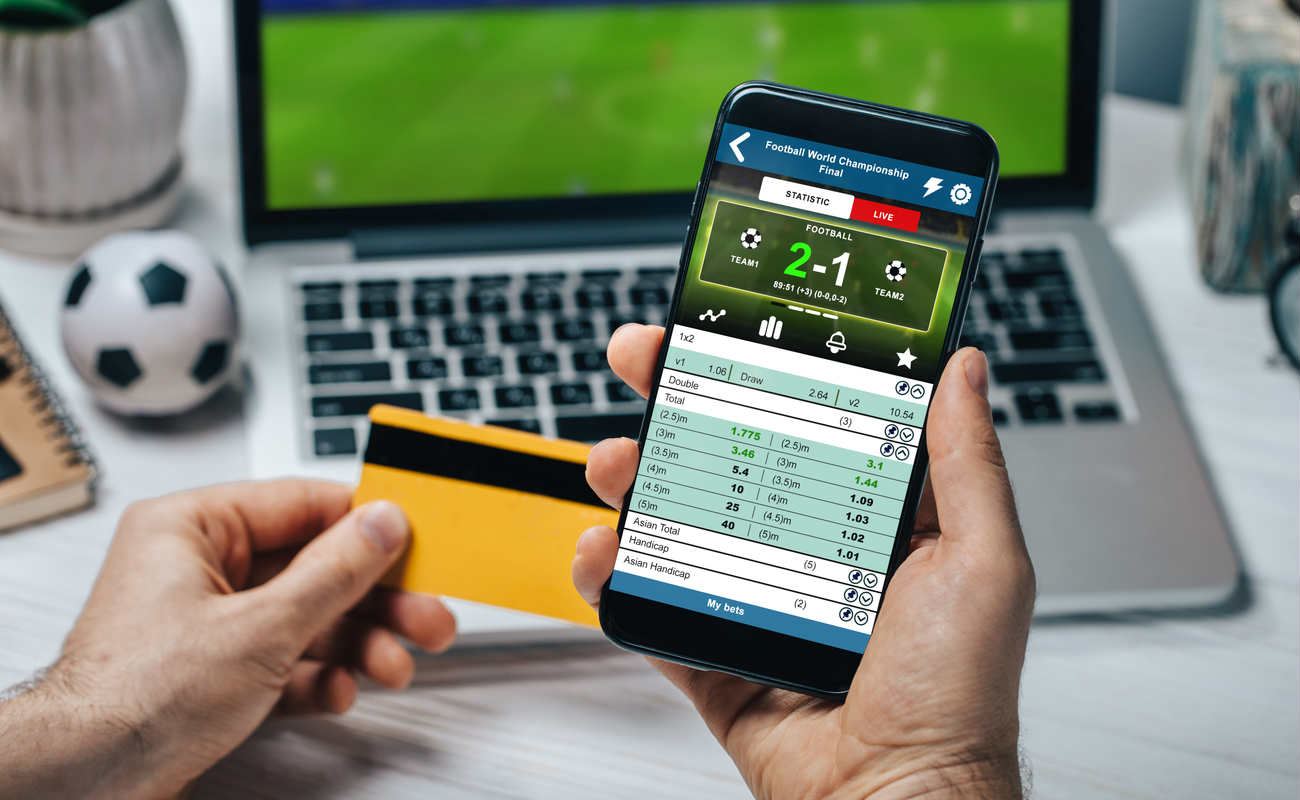

It would be a dream if many workers would quit their boring jobs once and for all to become professional sports betting investors. Professional betting looks attractive and lucrative. Surely…

Among gambling enthusiasts, sports betting has lost some of its attention in recent months and years in light of the massive poker boom, but that should not obscure the fact…

The virtual gambling business is booming - the number of registered members on German-language casino platforms on the Internet has never been as high as it is today. Virtual gambling…

The 22Bet uses the latest technology to ensure a safe and secure gaming experience. All transactions are encrypted to ensure that players' funds and data are always safe and secure. The customer support team is available 24/7 to answer any questions or provide assistance.

Players can choose from a variety of payment methods, including credit and debit cards, e-wallets, and bank transfers. All deposits and withdrawals are processed quickly and securely.

22Bet also offers a great selection of live dealer games. Players can interact with real dealers and play classic casino games such as blackjack, roulette, and baccarat. Players can also take part in tournaments and win big prizes.

22Bet offers an exciting gaming experience for players who want to enjoy the thrill of casino gaming. With a wide selection of games, bonuses, and promotions, 22Bet is sure to provide players with an enjoyable and rewarding gaming experience.